Umfangreiche Daten von Bürgern sind Anfang März 2023 kompromittiert worden! In den vergangenen Tagen sind vermehrt Anzeigen gegen Unbekannt wegen Datenmissbrauch und Erpressungsversuchen bei mehreren Polizeidienststellen in der Bundesrepublik Deutschland eingegangen. Unbekannte habe trotz eines Schutzes durch Verschlüsselung Zugriff auf persönliche Daten erlangt und damit die Besitzer erpresst. Außerdem wurden viele Fälle bekannt, bei denen es gelungen ist, in Online-Banking-Verfahren einzudringen und dabei Bankkonten leerzuräumen. Das Bundesamt für die Sicherheit in der Informationstechnik (BSI) empfiehlt, z.Zt. auf Online-Banking zu verzichten und bei Bedarf Geld nur bar abzuheben. Erste Vermutungen weisen auf ein erfolgreiches Brechen des Verschlüsselungsmechanismus hin. Gibt es Hinweise auf die Nutzung von sogenannten Quantencomputern, mit deren Hilfe es ein Leichtes ist, asymmetrische Verschlüsselungsverfahren 1) (auch Public Key Kryptoverfahren genannt) auszuhebeln?

Oberst a.D. Peter Warnicke

Nun, erfreulicher Weise ist diese Geschichte nur eine Fiktion! Oder doch eher ein Blick in die Zukunft? Genau dieses in der Öffentlichkeit noch nicht so richtig angekommene Szenario, nur noch deutlich weiter gedacht, war Thema einer Fachveranstaltung, die die AFCEA Bonn e.V. am Donnerstag, den 16. März 2023 bei der Fraunhofer-Gesellschaft FKIE in Wachtberg-Werthofen durchgeführt hat: Cyber-Sicherheit im Zeitalter der Quantentechnologie.

Dazu wurden vier namhafte und fachlich überaus kompetente Experten aus Forschung, dem Bundesamt für die Sicherheit in der Informationstechnik (BSI) und Industrie eingeladen. Beleuchtet wurde die Frage, wie auf das Bedrohungspotential von überaus leistungsfähigen Quantencomputern reagiert werden muss, um die Cyber-Sicherheit in der Zukunft sicherstellen zu können.

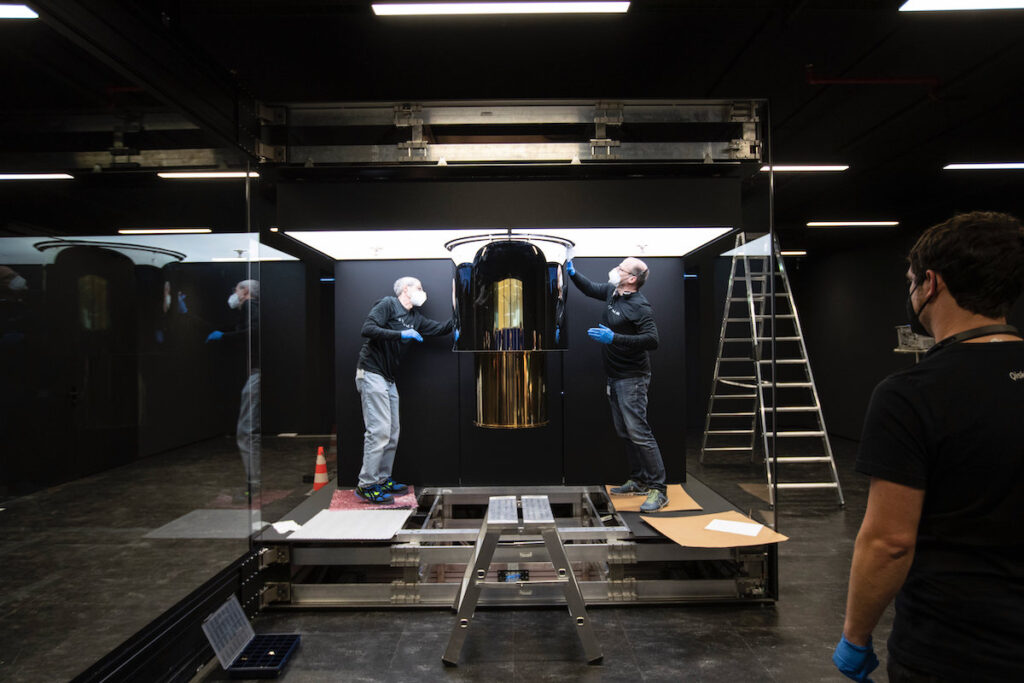

Und die Zukunft hat ganz offensichtlich längst begonnen: Erste Prototypen von Quantencomputern gibt es seit 2011 von der kanadischen Firma D‑Wave Systems. Aktuelle Systeme wie z. B. Googles Quantencomputer “Sycamore” (2019) und der “Quantum System One“ von IBM (siehe Abbildung 1a, 1b und 1c), der übrigens von der Fraunhofer-Gesellschaft 2021 im baden-württembergischen Ehningen in Betrieb genommen wurde, sind mittlerweile noch deutlich leistungsfähiger. Und im Forschungszentrum Jülich wird bereits an “QSolid”, dem ersten echten Quantencomputer mit ausschließlich deutscher Technologie gearbeitet – 2024 soll er betriebsbereit sein.

Abb. 1a: IBM Quantum System One in Ehningen, Germany; Foto: Urheber – IBM Research

Quelle: https://www.flickr.com/photos/ibm_research_zurich/51248690716/

Abb. 1b: Der IBM Quantum System One in Ehningen ist der bisher leistungsstärkste Quantencomputer in Europa, an dem Industrie und Forschungsorganisationen jetzt unter deutschem Recht anwendungsbezogene Quantensoftware entwickeln, testen und ihre Kompetenzen ausbauen können; Foto: Urheber – IBM Research,

Quelle: https://www.flickr.com/photos/ibm_research_zurich/51248884043

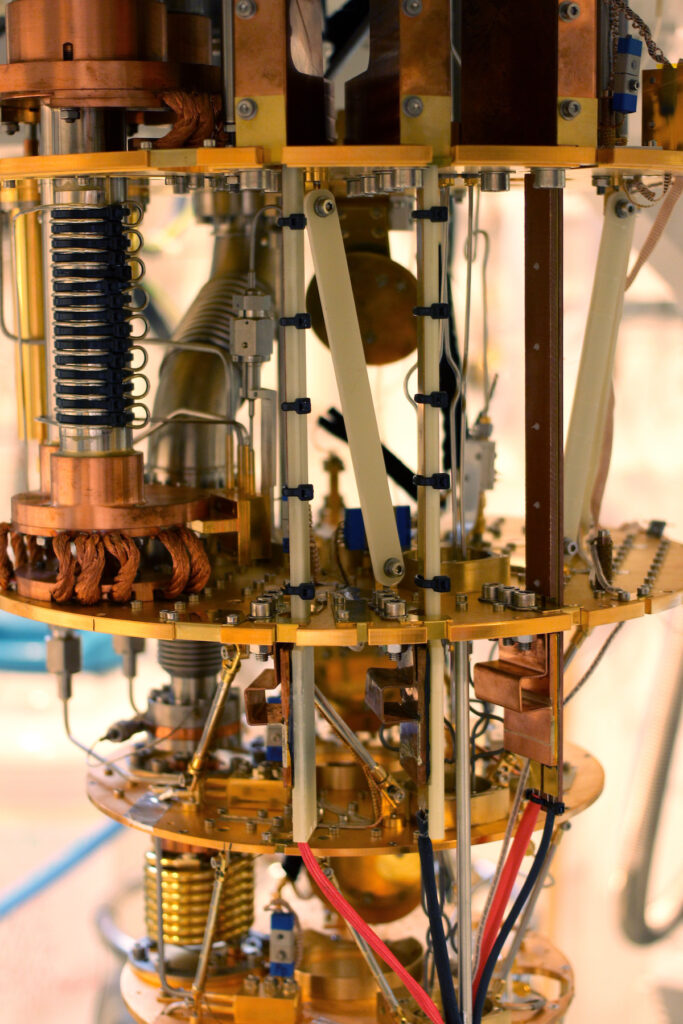

Abb. 1c: Hochleistungskühlsystem, das im Quantencomputer Quantum System One genutzt wird. Im Betrieb ist es vollständig in einem versiegelten und isolierenden Gehäuse eingeschlossen. In jeder Kaskade ist die Temperatur nach unten hin niedriger. Das obere Regal hat eine Temperatur von etwa 50 Kelvin (-223 Grad Celsius), das nächste nach unten liegt bei etwa 4,4 Kelvin (-269 Grad Celsius), dann 0,08 K und schließlich 0,03 K (-273 Celsius), knapp über dem absoluten Nullpunkt (0 K). Auf dem thermische Effekte wie die Vibration der Atome eliminiert werden, so dass Quanteneffekte beobachtet werden können. Das Kühlsystem, das mit einer Mischung aus Helium‑3 und Helium‑4 gekühlt wird, befindet sich in der Abteilung für Physik und Astronomie des University College London (UCL).

Foto: Urheber – UCL Mathematical and Physical Sciences from London, UK; Quelle: https://commons.wikimedia.org/wiki/File:Quantum_refrigerator_at_UCL_(17626619658).jp

Verglichen mit herkömmlichen Hochleistungsrechnern sind Quantencomputer theoretisch Millionen Mal schneller! Noch aber ist es nicht gelungen, Quantencomputer wie die heute verfügbaren Computer frei zu programmieren. Bisher sind sie nur geeignet, ganz spezielle Aufgabenstellungen zu lösen. So wurde z.B. gezeigt, dass der Sycamore-Prozessor Zufallszahlen einer speziellen Wahrscheinlichkeitsverteilung in nur 200 Sekunden ermittelt hat. Der seinerzeit schnellste Supercomputer der Welt – Summit von IBM (siehe Abbildung 2) – hätte nach einer Abschätzung zufolge wahrscheinlich 10.000 Jahre dafür benötigt. Das Potential, insbesondere die außergewöhnlich hohe Rechenleistung von Quantencomputern, die exponentiell mit der Erhöhung ihrer Basiseinheit, dem Quantenbit (Qubit), ansteigt, ist also eine Investition in die Zukunft – und eine Bedrohung zugleich.

Abb. 2: Summit ist ein Supercomputer des Unternehmens IBM, der im Oak Ridge National Laboratory in den USA im Juni 2018 in Betrieb genommen wurde. Zum Zeitpunkt der Inbetriebnahme war er der schnellste Supercomputer der Welt; 4608 Rechner füllen über 200 Standard-19-Zoll-Racks, auf 520 qm, Foto: Urheber – Carlos Jones/ORNL;

Quelle: https://commons.wikimedia.org/w/index.php?curid=73905694

Was ist denn das Besondere bei der Quantencomputertechnik? Dort, wo der klassische Computer auf Basis von zwei Schaltzuständen elektronischer Schaltkreise arbeitet, nutzt man beim Quantencomputer quantenmechanische Zustände geeigneter Systeme. Als Quant wird das kleinstmögliche Element einer physikalischen Einheit bezeichnet, z.B. ein Elektron, ein Ion oder ein Photon. Dieses Quant bildet die Basis für das Quantenbit (Qubit). Es ist die kleinste Recheneinheit eines Quantencomputers, ähnlich wie das Bit bei einem herkömmlichen Computer. Quanten haben aber die Besonderheit, dass sie gleichzeitig die Kombination aus Ihren Zuständen 0 und 1 einnehmen können. Man spricht hier von Quantenverschränkung und Superpositionsprinzip. Damit ist beim Rechnen die Verarbeitung verschiedener Eingabewerte gleichzeitig möglich. In der Welt der Quanten gelten eben Gesetze, die mit unserer Alltagserfahrung nicht in Einklang zu bringen sind. „Schrödingers Katze“ 2) lässt grüßen!

Die Quantenphysik handelt von Wahrscheinlichkeiten, mit der bestimmte Ereignisse zutreffen. Und die Tatsache, dass ein Qubit mehrere Zustände gleichzeitig einnehmen kann, lässt offensichtlich Unschärfen zu. Diese Fehlerquelle wird durch das Wiederholen von Rechenoperationen aber minimiert. Und durch die Skalierung von vielen Qubits lassen sich letztlich sehr viele Rechenoperationen parallel durchführen, während herkömmliche Computer sie nur nacheinander abarbeiten können.

Ein Problem beim Quantencomputer stellt die exakte Steuerung der Zustände der Qubits und deren Stabilität dar. Jede Beeinflussung von außen, z. B. beim Messen des Zustands des Quant, aber auch jedwede Strahlung, Wärme oder Erschütterungen könnte seinen Zustand verändern. Um mit Qubits exakt rechnen zu können, werden sie deshalb in die Nähe des absoluten Nullpunkts (- 273,15°C) herunter gekühlt und gegen Erschütterungen, magnetische und elektrische Felder und alle anderen möglichen äußeren Einflüsse abgeschirmt.

Der erste Redner des Abends war Herr Prof. Dr. Christof Wunderlich, Professor für Quantentechnologie an der Universität Siegen sowie Gründer und CEO der “eleQtron GmbH”. Mit seiner über 20-jährigen Erfahrung durch seine Forschung auf dem Gebiet der Quantencomputer gehört er zu den ausgewiesenen Fachleuten auf diesem Gebiet. Er stellte seine Sicht auf den aktuellen Stand der Forschung und Technik dar. Zunächst ging er auf die Besonderheit der Quantentechnik ein, nämlich der Tatsache, dass sich mit einem Qubit gleichzeitig zwei Energiezustände darstellen lassen: Mit 8 Qubits bereits 256 (2 8) und mit 30 Qubits bereits ca. 1 Milliarde. Diese exponentielle Steigerung lässt bei Quantencomputern mit dem Tag, an dem es gelingt, sie frei programmierbar zu machen, eine Leistungssteigerung in Rechenleistung und Problemlösung erwarten, die alle heutigen Beschränkungen in der Rechenleistung geradezu pulverisieren. Nach Professor Wunderlich ist ihre “MAGIC-Technologie” ein echter Meilenstein bei der Nutzung von Quantencomputern (MAGIC = Magnetic Gradient Induced Coupling). Mit ihr ist man in der Lage, Ionen-Qubits mit Hochfrequenzwellen exakt und verlässlich zu steuern. Das MAGIC-Konzept wird das Problem bei der Rechengüte nach seiner Aussage gegenüber den anderen Ansätzen der Supraleiter-Technik durch perfekt reproduzierbare Qubits, stark reduzierte Kühlanforderungen und der sehr gut integrierbaren Hochfrequenztechnik für die Steuerung der Qubits deutlich verringern oder gar beseitigen. Als mögliche Anwendungen sind chemische und biologische Analysen, speziell auch medizinische Design-Fragen (Herstellung von Impf- und anderen Wirkstoffen), Optimierungssysteme und logistische Fragestellungen besonders geeignet für Lösungen mit Quantencomputern.

Nach dem Blick in die Zukunft der Quantencomputer verdarb Frau Dr. Heike Hagemeier vom BSI die Stimmung auf dem Weg in eine phantastische Computerwelt ein wenig durch ihre Sicht auf die durch Quantencomputer gefährdeten Kryptographie-Systeme. Mit ihrem Thema “Post-Quanten-Kryptographie für die nationale Sicherheit” (engl.: Post Quantum-Cryptographie = PQC) zeichnete Sie eine Gefährdungslage, in der zumindest asymmetrische Verschlüsselungssysteme in der Welt der Quantencomputer der Zukunft wirkungslos sein werden, da sie innerhalb weniger Minuten geknackt werden können. Ihre Hypothese: Anfang der 2030er Jahre wird es die ersten kryptografisch relevanten Quantencomputer geben, also Computer, die zumindest asymmetrische Kryptographie brechen können. Damit wäre jegliche Kommunikation auf Basis von Public-Key-Verfahren unsicher, so z.B. auch das Home-Banking in der heutigen Form. Aber sind aktuelle symmetrische Verfahren 3) dann noch sicher? Hier zumindest eine kleine Entwarnung: Die symmetrischen Krypto-Verfahren mit längeren Schlüsseln (mindestens 256 bit) sind nach Aussage von Dr. Hagemeier noch nicht in Gefahr. Gegebenenfalls könnte man mit der Verlängerung der Schlüssel entgegenwirken. Gleichwohl muss man sich mit den Fragen beschäftigen, wie lange die Daten von heute geschützt werden müssen (länger als 5 Jahre?), wie lange eine Umstellung auf quantensichere Kryptographie dauert und wie lange es dauert, bis Quantencomputer verfügbar sind. Denn die Gefahr, dass Datenströme heute aufgezeichnet werden und später unter Nutzung von Quantencomputern geknackt werden können („store now, decrypt later!), ist relevant .

Frau Dr. Hagemeyer berichtete in diesem Zusammenhang von einem BSI-Leitfaden zu diesem Thema. Danach wird es langfristig eine Post-Quanten-Kryptografie als Standard geben und ein Umstieg auf Quantencomputer-resistente Verfahren sollten bereits heute geplant werden. Eine flexible Anpassung sollte bei der Neu- und Weiterentwicklung von Krypto-Produkten im Vordergrund stehen (Stichwort „Kryptoagilität“). Die Post-Quanten-Verfahren sollten möglichst in Kombination mit klassischen Verfahren eingesetzt werden (hybride Nutzung). Ihr Fazit: Jetzt Risikoanalysen anstellen, um frühzeitig und kontinuierlich eine Migrationsstrategie zu erstellen, die bis Anfang der 2030er Jahre den Schutz vor Quantencomputer-Angriffen gegen die Krypto-Verfahren sicherstellt. Eine aktuelle Umfrage bei deutschen Unternehmen allerdings zeigt, dass man bisher noch recht blauäugig in die Zukunft der Quantencomputer-Welt schaut. Das sollte sich nach Meinung von Frau Dr. Hagemeier schleunigst ändern.

Herr M.Sc. Jan Philipp Thoma vom Horst-Görtz-Institut der Ruhr-Universität Bochum führte mit dem dritten Vortrag des Abends in die Welt der Cyber-Sicherheit durch Quantentechnologie. Er berichtete von einem Wettbewerb des US-amerikanischen National Institute of Standards and Technologie (NIST) 4), der 2016 begann und Kandidaten für Verschlüsselung und digitale Signaturen sucht, die selbst Angriffen von Quantencomputern standhalten können. Von ursprünglich 69 Bewerbern wurden bis 2020 zunächst sieben, bis zum heutigen Tag schließlich vier Kandidaten ausgewählt. Von diesen wurden drei mit deutscher Beteiligung entwickelt (Universität Bochum). Da der Wettbewerb noch nicht abgeschlossen ist, werden vier weitere Kandidaten in die abschließenden Betrachtungen mit eingeschlossen. Unabhängig von zukünftigen Krypto-Algorithmen erklärte auch Herr Thoma, dass die aktuellen symmetrischen Krypto-Verfahren nach heutigem Kenntnisstand “Quanten-sicher” sind, die asymmetrischen Verfahren dagegen nicht. Er ging dann auf die vier ausgewählten Verfahren ein: Crystals-Kyber/ ‑Dilithium, aber auch Falcon, SPHINCS+ und NtruEncrypt sind die Namen der vier neuen Krypto-Algorithmen 5), an die wir uns in der Zukunft wohl gewöhnen müssen. Wahrscheinlich wird sich für die meisten Anwendungsfälle der Lattice-basierte 6)Verschlüsselungsalgorithmus Crystals-Kyber durchsetzen, wenn die Frage der Patentrechte geklärt werden kann. Für digitale Signaturen käme dann Crystals-Dilithium in Frage. Aufgrund der vergleichsweise großen Signaturen werden Falcon und SPHINCS+ wohl zusätzlich standardisiert. Falcon ermöglicht kleine Signaturen, wobei die Implementierung wegen einer komplexen Datenstruktur etwas schwieriger sei. SPHINCS+ gilt als überaus sicher, weil der Algorithmus auf der lange bekannten kryptographischen Technik der Hash-Verfahren 7) basiert. Dafür sind die Signaturen hier wieder relativ groß. In der Betrachtung der Vor- und Nachteile der verschiedenen Lösungen kam Herr Thoma auch auf sogenannte Seitenkanalangriffe zu sprechen. Hierbei handelt es sich um die Auswertung kompromittierender Informationen, die über physische Informationen (z.B.durch Abstrahlung oder Auswertung von Energieflüssen), ggf. mangelhafte Implementierung eines Krypto-Systems in einem Gerät oder auch einer Software ausgelesen werden können. Daraus lassen sich Rückschlüsse auf die Verschlüsselung ziehen. Dem muss man z.B. durch Abschirmung der Systeme entgegen wirken. Für die künftigen Implementierungen ist auch nicht uninteressant, dass z.B. bei Crystals-Kyber eine Schlüssellänge von 2.400 Byte (1 Byte = 8 bit) veranschlagt wird, während heutige Kryptoalgorithmen wie ECDH (Elliptic Curve Diffie-Hellmann 8) ) “nur” 256 bit beinhalten. Ein Unterschied um Faktor 75! Das ist nicht unerheblich für die Performance künftiger Krypto-Systeme.

Frau Leonie Bruckert von der Firma Secunet Security Networks AG, Expertin für PQC, schließlich referierte über den Stand der Sicherheit der aktuellen VS-Produkte. Sie teilte die Risikoanalyse der Vorredner grundsätzlich. Auch sie zitierte bezüglich der Verfügbarkeit erster für die Kryptographie relevanter Quanten-Computer das BSI mit dem Jahr 2030 und die NSA mit der Aussage bis zum Jahr 2035. Daraus resultiere eine “unmittelbare Gefahr” für Daten der Stufe GEHEIM. Darum sollten Quanten-resistente Krypto-Algorithmen bis Anfang der 2030er Jahre abgeschlossen und in die Verschlüsselungssysteme implementiert sein. Für die Hersteller von kryptographischen Systemen sind die Vorgaben des BSI essenziell. Die Migration zur Post-Quantum-Kryptographie des BSI umfasst die Stufen: Verfügbarkeit von standardisierten Algorithmen – Integration von PQC in Produkten – Implementierungssteuerung – Hardwareunterstützung – Entwicklung und Zulassung von VS-Produkten – sichere Verteilung bei den Kunden. Die Handlungsempfehlung des BSI “Migration zu Post-Quanten-Kryptografie” ist im August 2020 aktualisiert worden. Das BSI empfiehlt in diesem Zusammenhang aktuell konservative PQC-Verfahren und große Schlüssel bei den Signaturen. Ein erster Meilenstein bei PQC-resistenter Hardware ist erreicht worden: SINA H (Verschlüsselungssystem bis GEHEIM) hat eine Zulassung bis 2030. Damit dürfen SINA Workstation H, SINA L3 Box H und SINA Workstation H (nur bis 2023) für die Verarbeitung entsprechend eingestufter Informationen weiter genutzt werden. Aber nationale Zulassungsverfahren benötigen durchaus einige Zeit, so dass man sich mit dem Einbringen geeigneter Kandidaten nicht zu lange Zeit lassen sollte. Auch die Implementierung in laufende Systeme und Anwendungen wird einige Zeit in Anspruch nehmen. Aber für Schlüsseleinigungsverfahren (arbeitet mit privatem und öffentlichen Schlüsseln nach Diffie-Hellman) wartet das BSI nicht auf die Entscheidungen des NIST und empfiehlt daher aktuell noch die Algorithmen FrodoKEM und Classic McEliece 9), da Handlungsbedarf bei den asymmetrischen Verfahren bestand.

Zum Abschluss sei festgestellt, dass der für die Auswahl der Programme und Themen bei AFCEA Bonn e.V. zuständige Herr Henry Günter Neumann mit der Einladung von Herrn Prof. Dr. Christof Wunderlich, Frau Dr. Heike Hagemeier, Herrn M.Sc. Jan Philipp Thoma und Frau Leonie Bruckert meines Erachtens eine ausgewogene und kompetente Expertenrunde für die Vorträge zu diesem Thema hat gewinnen können. Und es sollte am Ende dieses Beitrags deutlich geworden sein, dass jeder Bürger, jedes Industrieunternehmen und die staatlichen Institutionen in unserem Lande in einer nicht allzu fernen Zukunft in einer Welt der Quantencomputer sehr starken Bedrohungen ausgesetzt sein werden. Es gilt also, rechtzeitig auf allen Ebenen Vorsorge zu treffen, um persönlich Daten, industrielles Wissen und staatliche Geheimnisse „post-quanten-sicher“ zu machen. Das Thema wird laut Herrn Neumann im nächsten Jahr in der AFCEA-Vortragsreihe fortgesetzt.

Oberst a.D. Peter Warnicke war in seiner aktiven Dienstzeit u.a. zeitweise auch IT-Sicherheitsbeauftragter der Bundeswehr und ist Kassenwart des Fm-Rings e.V..

____________________________________

1) Asymmetrische Verschlüsselungsverfahren, auch Public-Key-Verschlüsselung genannt: Hier benötigt man zwei verschiedene Schlüssel, einen öffentlichen (Public Key) und einen privaten (Private Key). Diese beiden Schlüssel gehören untrennbar zusammen. Mit meinem öffentlichen Schlüssel, für jedermann zugänglich, werden Nachrichten an mich verschlüsselt. Sie können danach aber ausschließlich durch meinen privaten Schlüssel entschlüsselt werden. Dieses Verfahren hat sich in der E‑Mail-Kommunikation und auch im Home-Banking etabliert, weil es besonders einfach ohne den aufwendigen (sicheren) Austausch von Schlüsseln auskommt.

2) “Schrödingers Katze”: In einem Gedankenexperiment versuchte der österreichische Physiker und Wissenschaftstheoretiker Erwin Rudolf Josef Alexander Schrödinger (* 12.08.1887, † 04.01.1961), der als einer der Väter der Quantenmechanik gilt und 1933 den Nobelpreis für Physik erhielt, die Probleme bei der Interpretation der Quantenmechanik aufzuzeigen. Das Gedankenexperiment versucht, quantenmechanische Regeln in eine makroskopische Welt (die Welt der Katze) zu übertragen. Das Experiment: Eine Katze sitzt in einer verschlossenen Kiste, darin eine Giftkapsel, ein Geigerzähler und ein radioaktives (tödliches) Element. Wird der Geigerzähler durch den Zerfall des radioaktiven Elements ausgelöst, zerstört ein Mechanismus die Giftkapsel und die Katze stirbt. Nach einer Stunde beträgt die Wahrscheinlichkeit, dass das radioaktive Element zerfällt, 50 %. Solange die Kiste verschlossen ist, befindet sich die Katze im Prinzip in einem Zustand halb lebendig, halb tot. Das wird in der Quantenmechanik als “Superposition” dieser beiden Zustände bezeichnet – beide Zustände sind gleichzeitig möglich. Das Problem: Ob die Katze tot ist oder noch lebt, kann man nur durch das Öffnen der Kiste – also durch Beobachtung oder Messung – erfahren. Fazit: Die Regeln der Quantenmechanik lassen sich nicht einfach in die makroskopische Welt der Katze übertragen.

3) Symmetrische Verfahren – Ein gleicher Schlüssel, der an jeden Teilnehmer einer Gruppe auf einem sicheren Weg verteilt werden muss, wird für das Verschlüsseln wie auch für das Entschlüsseln einer Nachricht verwendet.

4) NIST – National Institute of Standards and Technology, Bundesbehörde der USA mit Sitz in Gaithersburg, Maryland. Die vom NIST ausgewählten Verfahren haben sich in der Vergangenheit regelmäßig weltweit als Krypto-Standards durchgesetzt.

5) Die vier neuen Krypto-Algorithmen:

a) Crystals-Kyber/ ‑Dilithium gehören zur Gruppe der Lattice-/ Gitter-basierten (siehe unten) Verschlüsselungsalgorithmen. Beim Crystals-Algorithmus werden besonders schwierige mathematische Probleme als Basis des Algorithmus ausgesucht. Kyber ist ein Schlüsselkapselungsverfahren (Key Encapsulation Mechanism = KEM). Hier wird der Schlüssel-Algorithmus mit einem asymmetrischen Verfahren verteilt. Der Crystals-Dilithium-Algorithmus ist für digitale Signaturen ausgewählt. Das NIST empfiehlt bereits jetzt, die Crystals-Verfahren zu nutzen, da sie als Quantenrechner-resistent gelten.

b) Falcon wurde von der Firma Thales in Zusammenarbeit mit akademischen und industriellen Partnern aus Frankreich, der Schweiz, Kanada und den USA gegen Angriffe von leistungsstarken Quantencomputern entwickelt. Der Falcon-Algorithmus wurde vom NIST für die Verwendung bei digitale Signaturen ausgewählt.

c) SPHINCS+ ist ein Hash-basiertes (siehe unten) Signaturverfahren, das entwickelt wurde, um langfristig Sicherheit gegen Angriffe mit Quantencomputern zu bieten.

d) NtruEncrypt ist ein asymmetrisches Verschlüsselungsverfahren, das auf der Berechnung von Lattice-/ Gitterproblemen (siehe unten) basiert, die selbst mit Quantencomputern als nicht knackbar gelten. Das Verfahren wurde bisher allerdings noch nicht so gut untersucht, wie die gängigeren Verschlüsselungsverfahren.

6) Lattice-basierte Verschlüsselungsverfahren (Lattice, engl. für Gitter) sind Verfahren, die auf einem speziellen mathematischen Problem beruhen. Mathematisch besteht ein Gitter aus einem Raster unendlich vieler Punkte. Ein Beispiel für ein mathematisches Problem ist die Berechnung des nächst gelegenen Gitterpunktes eines außerhalb der Kreuzungspunkte liegenden zufälligen Punktes. Die Berechnung dieses Vektors ist in einem 2- oder 3‑dimensionalen Raum kein so großes Problem. Nimmt man aber – mathematisch – ein 512-dimensionales Gitter, dann bekommt auch ein Quantencomputer ein kaum lösbares Problem. Man darf hier aber, wie bei anderen Post-Quantum-Ansätzen nicht außer Acht lassen, dass sich die Idee effizient umsetzen lassen muss. Die Signaturen bzw. Schlüsseltexte dürfen also nicht zu groß werden.

7) Hash-Verfahren werden zur Identitätsprüfung genutzt (engl. to hash = zerhacken). Mit einer Funktion wird aus einer großen Eingabemenge eine kleinere Zielmenge abgebildet. Der sogenannte Hash-Wert einer Datei oder Nachricht wird dann mit einem bekannten Wert verglichen. Das Rückwärtsrechnen, also das Berechnen des Eingabewerts aus dem Hash-Wert ist unmöglich. Die kryptographische Hash-Funktion kann auch zur sicheren Speicherung von Passwörtern genutzt werden. Bei Prüfung des Passworts wird der Hash-Wert mit einen in einer Datenbank hinterlegten Hash-Wert verglichen.

8) Whitfield Diffie u. Martin Edward Hellman sind zwei amerikanische Kryptologen. Sie sind die Begründer des 1976 veröffentlichen Public-Key-Verfahrens, das erste sogenannte asymmetrische Krypto-Verfahren.

9) FrodoKEM ist ein Krypto-Algorithmus, der als Schlüsselkapselungsmechanismus (Key Encapsulation Mechanism = KEM) als konservative Post-Quanten-Kryptographie konzipiert und 2019 vom BSI als geeignet in hybriden Lösungen freigegeben wurde. Also ein klassischer symmetrischer Schlüssel verteilt über ein asymmetrisches Verschlüsselungsverfahren.

Classic McEliece ist ein vom Kryptographen Robert J. Mc Eliece im Jahre 1978 entwickelter Verschlüsselungsalgorithmus, der auf mathematischen Matrizen basiert. Weil er für die Beschreibung eines 128 Bit starken Schlüssels ca. 1 MByte (ungefähr Faktor 7.800!) Speicherplatz benötigt, fand er bisher kaum Verwendung. Da er aber auch bei Verwendung von Quantencomputern als nicht zu brechen gilt, ist er als Kandidat für die Post-Quanten-Kryptographie vom BSI wie auch vom NIST ausgewählt worden.